出於書本 Chapter 14. Web sites and Applications

網站與網路應用程式因很容易透過網路存取,每個人都可以透過網路對網站進行探測。一般網站可能包含有公司行號的行銷資訊 (Marketing)、聯絡資訊與檔案下載等等,容易成為攻擊的對象(特別是要炫技的小屁孩 kiddie )。對於犯罪型的駭客來說,網站提供了一個存取像有價值的資訊的前端 (front-end)。

如前面幾個章節作者都會列一些測試工具,這裡也有列了一些網路應用程式的相關測試工具,其中

一般的弱點掃描工具也能拿來替網站做安全性檢測。

大部分的攻擊,就算是使用 HTTPS 也一樣能夠實現,因為傳輸媒介 (communications medium) 根本無法防範攻擊,漏洞實際上發生的位置會是在網站或是網路應用程式本身,或是這些程式所架設的伺服器上。

目錄遍歷 (Directory traversal) 是一種很經典的網站攻擊方式,攻擊者透過瀏覽網站的結構來找出一些蛛絲馬跡,像是伺服器的資料結構與敏感的檔案,很有可能有意無意地就被找出來。書上介紹使用下面的測試確認網站的目錄結構:

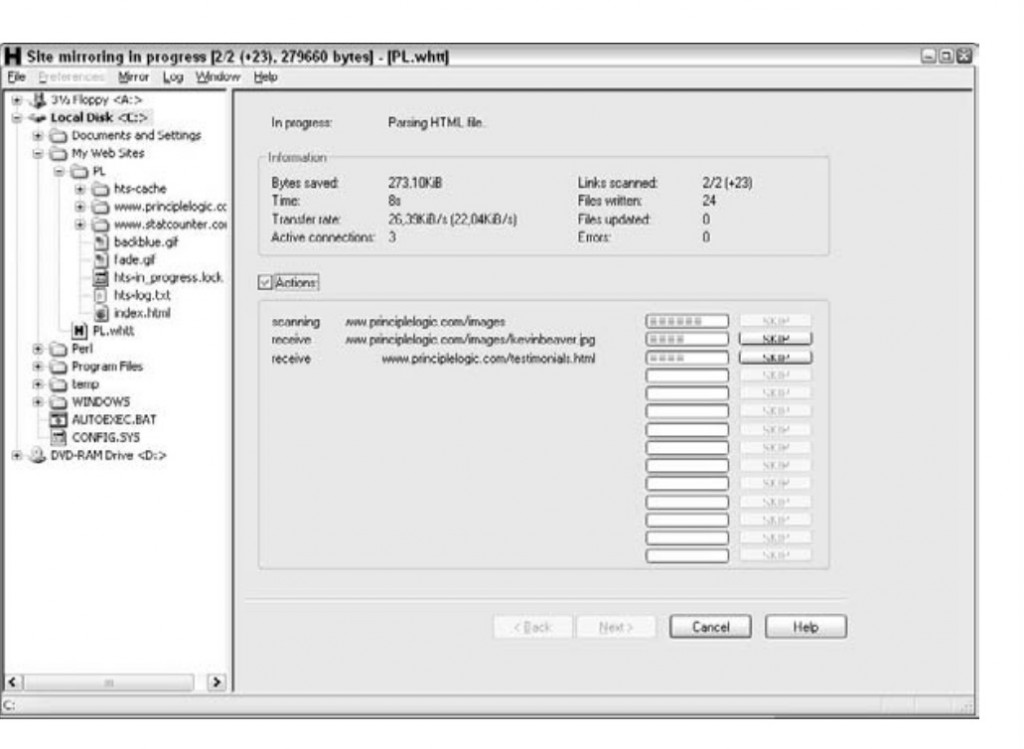

HTTrack Website Coper ,能夠爬出所有能被公開存取的檔案。HTTrack Website Coper 範例,如果掃描出來的只有一般網站在使用的 HTML 與 PDF 檔案,沒有夾帶什麼不想公諸於世的敏感資訊,就不會有太大問題。

搜尋引擎也能拿來做目錄遍歷,使用的方式就是在 google 的搜尋列裡下進階的 Google Queries 語法,像是

// 可以打任意像是

信用卡、機密等等用關鍵字組成的 list

site:hostname keywords// 可以搜尋站台中任意種類的檔案,比如

.zip或是

filetype:file-extension hostname

其他進階的 Google operators 像是

robots.txt 檔案來防範來自搜尋引擎爬蟲程式必要的檔案或資料夾能透過網際網路存取最後,可以考慮使用搜尋引擎的 誘捕系統 (a.k.a Honey Pot) ,例如 Google Hack Honeypot 來看看壞人都是如何透過搜尋引擎操作網站並且防範他們。

明天來看看 Input filter 相關的攻擊~晚安啦~